ChatGPT ≠ AI:揭开人工智能与大模型的本质差异

“ChatGPT是不是AI?”这个问题频频出现在技术圈、媒体乃至普通用户口中。实际上,把ChatGPT等同于AI,就像把微波炉等同于“烹饪”本身。ChatGPT只是AI发展长河中的一项应用,背后还有更广阔、系统的技术地图。

本文将带你深入剖析:

- AI的完整技术版图及主流子领域

- ChatGPT在AI生态中的层级与定位

- 大模型(LLM)及Transformer等核心原理

- ChatGPT的工作机制与局限分析

- 常见AI术语拆解与理解

人工智能:远超ChatGPT的广阔领域

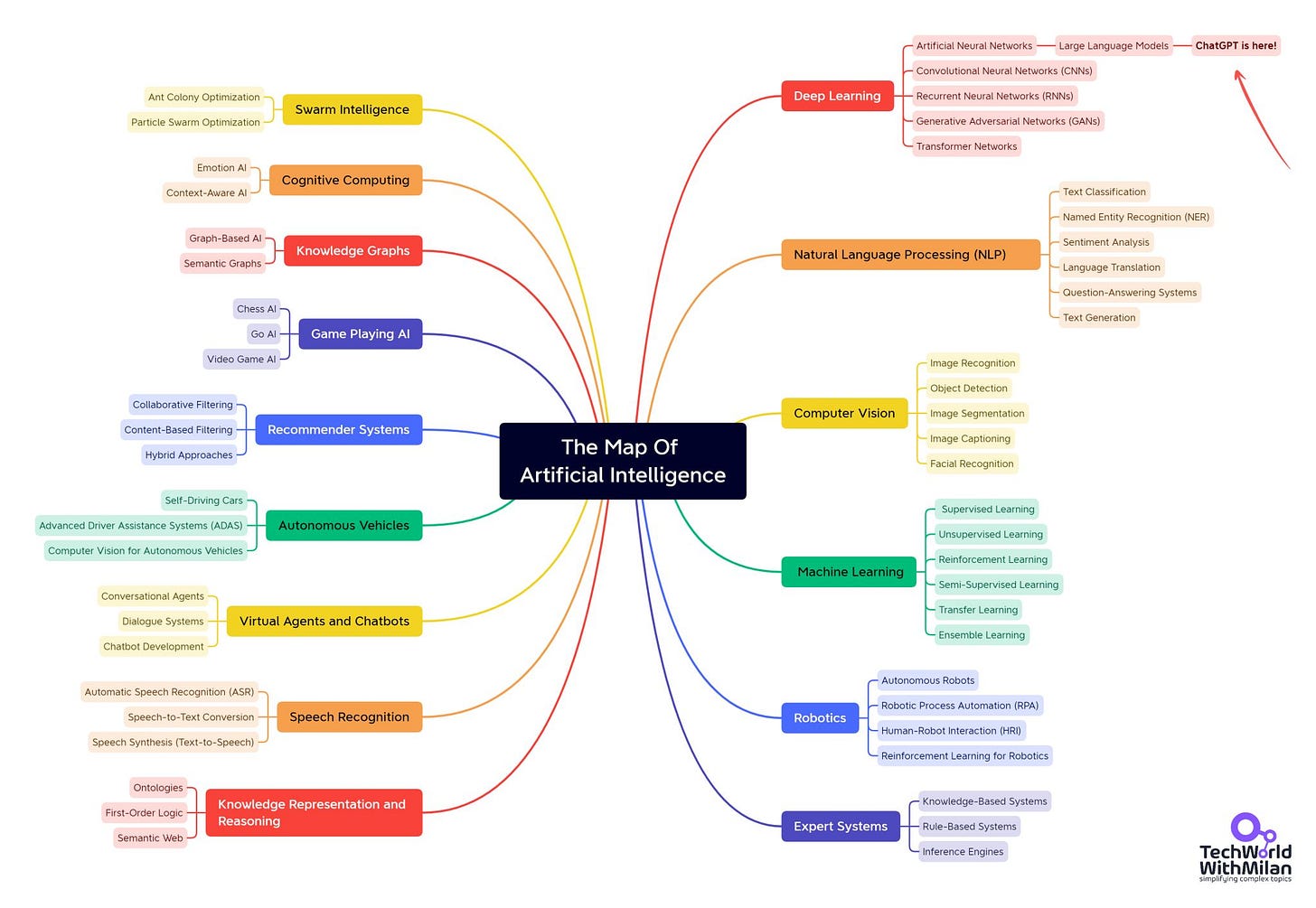

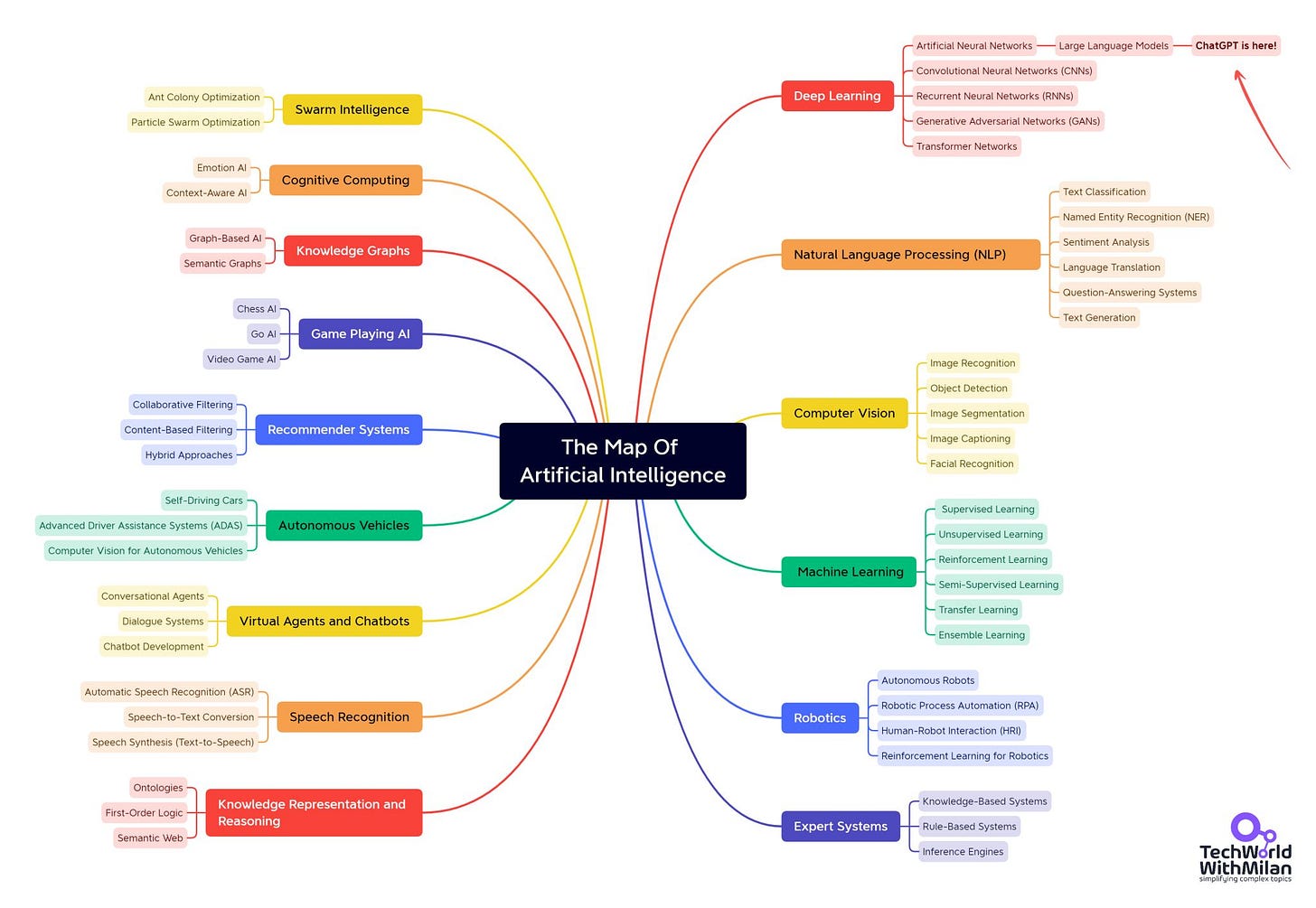

人工智能(AI, Artificial Intelligence)是一个涵盖广泛的总称,指的是让系统具备模拟人类认知(学习、推理、感知等)的能力。AI包括但不限于以下子领域:

- 机器学习(ML):算法通过数据“学习”规律而非硬编码,驱动了近十年AI浪潮。

- 自然语言处理(NLP):让计算机理解和生成自然语言,是ChatGPT这类大模型的基础领域。

- 计算机视觉(CV):让机器理解和分析图片、视频,如自动驾驶、医疗影像识别。

- 机器人学:结合AI与工程,实现物理世界中的任务自动化。

- 专家系统:基于规则的推理决策系统,是AI的早期形态。

实际上,自动驾驶、医学影像诊断、智能语音助手等,都是AI落地的不同分支。ChatGPT不过是NLP领域一个极具代表性的应用。

ChatGPT:AI发展史上的“冰山一角”

要理解ChatGPT的本质,首先要梳理它在AI技术演变中的位置。从AI到ChatGPT,大致经历了以下技术路径:

-

AI(人工智能) 泛指所有模仿人类智能的技术,既包括基于规则的专家系统,也包括数据驱动的现代机器学习。

-

神经网络(Neural Networks, NN) 模仿人脑神经元结构构建,通过大量参数训练出复杂非线性映射。

-

深度学习(Deep Learning, DL) 以多层神经网络为核心,自动提取分层特征,推动图像识别、语音识别、NLP等领域重大突破。

-

Transformer架构 2017年Google提出的“Attention is All You Need”模型,首次用自注意力机制实现输入序列的并行建模,颠覆了RNN、CNN等传统模型。

-

大语言模型(LLM, Large Language Model) 基于Transformer,参数量达到数十亿乃至千亿,利用大规模语料“预训练+微调”习得丰富的语言能力,代表有GPT、BERT、PaLM等。

-

GPT系列(Generative Pre-trained Transformer) OpenAI提出的系列大模型:

- GPT-1(2018)首次证明预训练+微调的有效性;

- GPT-2(2019)参数量达15亿,引发文本生成热潮;

- GPT-3(2020)参数量飙升至1750亿,多任务零样本能力大幅提升;

- GPT-4(2023)、GPT-4o(2024)实现多模态、超长上下文、推理能力提升。

- 2025年新一代如o3等,强调推理透明性、推理优先等。

-

ChatGPT 以GPT-4为底座,通过指令微调和人类反馈强化学习(RLHF),让模型在对话场景下表现出强大的交互能力、知识迁移能力。ChatGPT是AI大厦的“应用层”产品,负责将深度模型能力包装为易用的对话接口。

ChatGPT的工作原理深拆

ChatGPT表面上是“智能对话”,实质是极为复杂的数学建模、神经网络和大规模数据驱动。

预训练与微调:海量数据“自学成才”

-

预训练阶段(Unsupervised):通过海量无标注文本,预测下一个词,习得基本语言模型能力。此阶段无需人工标签,最大程度吸收知识。

-

微调与RLHF:少量有标注数据+人类反馈优化(Reinforcement Learning from Human Feedback),让模型输出更贴近人类价值观和交互习惯。

Transformer与自注意力机制:并行高效建模

-

自注意力(Self-attention):每个词与全句所有词进行加权关联,实现全局依赖关系建模,突破RNN等序列瓶颈。

-

多头注意力(Multi-head attention):并行捕捉不同语义信息,使模型理解长文本、复杂语境。

-

位置编码(Positional Encoding):让模型理解词序。

生成机制:逐词预测,非“理解”式推理

-

ChatGPT不是检索式,而是基于概率逐词生成(autogressive),每步选择下一个最可能的词。这种方式让输出自然流畅,但同时也带来了“幻觉”现象(hallucination),即模型自信生成看似合理、实则错误的信息。

-

这也导致了LLM的局限:模型没有“计划”,只会一次预测下一个最优词,对长文一致性、复杂推理、事实准确性天然存在短板。

RLHF与安全性:让大模型可控可用

-

RLHF(人类反馈强化学习)机制,通过人工标注优选输出,训练模型更符合用户预期,缓解输出不当、偏见、幻觉等问题,推动了大模型产品化和产业落地。

ChatGPT≠AI:认识技术边界与应用策略

ChatGPT的火爆让AI成为全民话题,但它只是AI系统中的一类代表。AI的完整能力版图远不止对话和文本生成,更多领域如计算机视觉、知识图谱、规划与推理、自动控制等,都有各自技术体系与代表性应用。

真正理解AI与ChatGPT的关系,有助于我们更理性选择工具,规避“万能论”误区。例如:

- ChatGPT是优秀的创作、总结、初步方案生成工具,但不能直接作为“权威事实源”;

- AI人才需系统理解底层原理、模型局限,而不仅仅是会用ChatGPT写prompt;

- 针对不同业务需求,需结合AI的多种子领域能力进行系统架构设计。

AI热门术语速查表(部分)

| 英文缩写 | 中文释义 | 技术重点 |

|---|---|---|

| AI | Artificial Intelligence | 人工智能总称,模仿人类认知 |

| AGI | Artificial General Intelligence | 通用人工智能,尚未实现 |

| ML | Machine Learning | 机器学习,数据驱动建模 |

| DL | Deep Learning | 深度学习,多层神经网络 |

| NLP | Natural Language Processing | 自然语言处理 |

| LLM | Large Language Model | 大语言模型 |

| GPT | Generative Pre-trained Transformer | 生成式预训练Transformer |

| RLHF | Reinforcement Learning from Human Feedback | 人类反馈强化学习 |

| RAG | Retrieval-Augmented Generation | 检索增强生成 |

| CNN | Convolutional Neural Network | 卷积神经网络,视觉领域 |

| Transformer | - | 自注意力架构 |

| Hallucination | 幻觉 | 大模型虚假生成现象 |

结语

ChatGPT是AI技术体系中的一颗明星,但绝非全部。理解其技术路径、架构机制和边界,有助于科学认知AI生态,为未来的技术应用和职业发展打下坚实基础。面对AI浪潮,我们既要欣赏ChatGPT等创新成果,也要看到更广阔的AI版图,做技术与场景的最佳结合者。

本文为基于Tech World With Milan Newsletter内容整理与扩展,图片均源自原文及相关论文资料,建议查阅原文获取更多细节与延伸阅读。